Введение

В эконометрике широко используются методы статистики. Ставя цель дать количественное описание взаимосвязей между экономическими переменными, эконометрика, прежде всего, связана с методами регрессии и корреляции.

В зависимости от количества факторов, включенных в уравнение регрессии, принято различать простую (парную) и множественную регрессии.

Простая регрессия представляет собой модель, где среднее значение зависимой (объясняемой) переменной у рассматривается как функция одной независимой (объясняющей) переменной х, т.е. это модель вида

Множественная регрессия представляет собой модель, где среднее значение зависимой (объясняемой) переменной у рассматривается как функция нескольких независимых (объясняющих) переменных х 1 , х 2 ,..., т.е. это модель вида

У = ѓ (х 1 , х 2 …, х k).

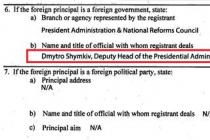

Методам простой или парной регрессии и корреляции, возможностям их применения в эконометрике посвящена данная работа.

Линейная регрессия и корреляция: смысл и оценка параметров

Линейная регрессия находит широкое применение в эконометрике ввиду четкой экономической интерпретации ее параметров. Линейная регрессия сводится к нахождению уравнения вида

y x = a + b * x или y = a + b * x + е. (1)

Уравнение вида y x = a + b * x позволяет по заданным значениям фактора x иметь теоретические значения результативного признака подстановкой в него фактических значений фактора x (рис 1)

Построение линейной регрессии сводится к оценке ее параметров - a и b. Оценки параметров линейной регрессии могут быть найдены разными методами. Можно обратиться к полю корреляции и, выбрав на графике две точки, провести через них прямую линию (см. рис.1), затем по графику найти значения параметров. Параметр a определим, как точку пересечения линии регрессии с осью oy а параметр b оценим исходя из угла наклона линии регрессии как dy/dx, где dy - приращение результата y, а dx - приращение фактора x т. е.

Классический подход к оцениванию параметров линейной регрессии основан на методе наименьших квадратов (МНК).

Метод наименьших квадратов позволяет получить такие оценки параметров а и b, при которых сумма квадратов отклонений фактических значений результативного признака у от расчетных (теоретических) у х минимальна:

У(yi - yx i) 2 > min (2)

Иными словами, из всего множества линий линия регрессии на графике выбирается так, чтобы сумма квадратов расстояний по вертикали между точками и этой линией была бы минимальной (рис. 2.):

е i = y i - y x ,

следовательно,

Для того чтобы найти минимум функции (2), надо вычислить частные производные по каждому из параметров a и b и приравнять их к нулю.

Обозначим У е i 2 через S, тогда:

S = У(y i - y x)2 = У(y - a - b *x)2 ;

dS / da = - 2Уy + 2 * n*a + 2 *bУx= 0; (3)

dS / da = - 2Уy * x + 2 *a Уx + 2 * b Уx 2 = 0.

Преобразовывая формулу (3), получим следующую систему нормальных уравнений для оценки параметров a и b:

N *a + bУx = Уy,

aУx + b Уx 2 = Уy * x. (4)

Решая систему нормальных уравнений (4) либо методом последовательного исключения переменных, либо методом определителей, найдем искомые оценки параметров а и Ь. Можно воспользоваться следующими формулами для a и b:

a = y - b * x (5)

Формула (5) получена из первого уравнения системы (4), если всего его члены разделить на n:

b = cov(x,y) / у 2 x

где cov(x,y) - ковариация признаков; у 2 x - дисперсия признака х.

Поскольку cov(x,y) = yx - y * x , а у 2 x = x 2 - x -2 , получим следующую формулу расчета оценки параметра b:

b = yx - y * x / x 2 - x 2 (6)

Формула (6) получается также при решении системы (4) методом определителей, если все элементы расчета разделить на n 2 .

Параметр b называется коэффициентом регрессии. Его величина показывает среднее изменение результата с изменением фактора на одну единицу. Так, если функция издержек (y, тыс. руб.) выражается как y x = 3000 + 2 * x , (x - количество единиц продукции), то, следовательно, с увеличением объема продукции x на одну единицу издержки производства возрастают в среднем на 2 тыс. руб., т. е. дополнительный прирост продукции на одну единицу потребует увеличения затрат в среднем на 2 тыс. руб.

Знак при коэффициенте регрессии b показывает направление связи: при b > 0 - связь прямая, а при b < 0 - связь обратная.

Возможность четкой экономической интерпретации коэффициента регрессии сделала линейное уравнение регрессии достаточно распространенным в эконометрических исследованиях.

Формально a - значение y при x = 0. Если признак-фактор x не имеет и не может иметь нулевого значения, то трактовка свободного члена a не имеет смысла. Параметр a может не иметь экономического содержания. Попытки экономически интерпретировать параметр a могут привести к абсурду, особенно при a < 0.

Интерпретировать можно лишь знак при параметре a. Если a < 0, то относительное изменение результата происходит медленнее, чем изменение фактора. Иными словами, вариация результата меньше вариации фактора - коэффициент вариации по фактору x выше коэффициента вариации для результата y: Vx > Vy. Для доказательства данного положения сравнимо относительные изменения фактора x и результата y:

Уравнение регрессии всегда дополняется показателем тесноты связи. При использовании линейной регрессии в качестве такого показателя выступает линейный коэффициент корреляции r xy . Имеются разные модификации формулы линейного коэффициента корреляции, например:

к чн = и * у ч. у н = сщм(чбн) . у ч * у н = нч - н * ч. у ч * у н (7)

Как известно, линейный коэффициент корреляции находиться в границах - 1 ? r xy ? 0.

Если коэффициент регрессии b > 0, то 0 ? r xy ? 1, и, наоборот, при b < 0 - 1 ? r xy ? 0.

Следует иметь в виду, что величина линейного коэффициента корреляции оценивает тесноту связи рассматриваемых признаков в ее линейной форме. Поэтому близость абсолютной величины линейного коэффициента корреляции к нулю еще не означает отсутствия связи между признаками. При иной спецификации модели связь между признаками может оказаться достаточно тесной.

Для оценки качества подбора линейной функции рассчитывается квадрат линейного коэффициента корреляции r 2 xy , называемый коэффициентом детерминации. Коэффициент детерминации характеризует долю дисперсии результативного признака у, объясняемую регрессией, в общей дисперсии результативного признака:

r 2 xy = у 2 y объясн. / у 2 y общ (8)

Соответственно величина 1 - r 2 характеризует долю дисперсии у, вызванную влиянием остальных, не учтенных в модели факторов.

Величина коэффициента детерминации является одним из критериев оценки качества линейной модели. Чем больше доля объясненной вариации, тем соответственно меньше роль прочих факторов и, следовательно, линейная модель хорошо аппроксимирует исходные данные, и ею можно воспользоваться для прогноза значений результативного признака. Линейный коэффициент корреляции по содержанию отличается от коэффициента регрессии. Выступая показателем силы связи, коэффициент регрессии b на первый взгляд может быть использован как измеритель ее тесноты. Величина коэффициента регрессии зависит от единиц измерения переменных, от размерности признаков. Кроме того, коэффициенты регрессии - величины именованные, и потому несравнимы для разных признаков.

Сделать коэффициенты регрессии сопоставимыми по разным признакам позволяет определение аналогичного показателя в стандартизованной системе единиц, где в качестве единицы измерения признака используется его среднее квадратическое отклонение (у). Поскольку коэффициент регрессии b имеет единицы измерения дробные (результат/фактор), то умножив, его на среднее квадратическое отклонение фактора х (у x) и разделив на среднее квадратическое отклонение результата (у y), получим показатель, пригодный для сравнения интенсивности изменения результата под влиянием разных факторов. Иными словами, мы придем к формуле линейного коэффициента корреляции:

r xy = b y/x * у x / у y

Его величина выступает в качестве стандартизованного коэффициента регрессии и характеризует среднее в сигмах (у y) изменение результата с изменением фактора на одну у x .

Линейный коэффициент корреляции как измеритель тесноты линейной связи признаков логически связан не только с коэффициентом регрессии b, но и с коэффициентом эластичности, который является показателем силы связи, выраженным в процентах. При линейной связи признаков х и у средний коэффициент эластичности в целом по совокупности определяется как

Э y/x = b y/x * x / y,

т.е. его формула по построению близка к формуле линейного коэффициента корреляции

r xy = b y/x * у x / у y ,

Как и линейный коэффициент корреляции, коэффициент эластичности сравним по разным признакам.

Если Э y/x = 0,8 %, а Э y/z = 0,2 % , то можно заключить, что фактор х в большей мере влияет на результат у, чем фактор z, ибо с ростом х на 1% у возрастает на 0,8 %, а с ростом z на 1 % - только на 0,2 %.

Несмотря на схожесть этих показателей, измерителем тесноты связи выступает линейный коэффициент корреляции (r xy), а коэффициент регрессии (b y/x) и коэффициент эластичности (Э y/x) - показатели силы связи: коэффициент регрессии является абсолютной мерой, ибо имеет единицы измерения, присущие изучаемым признакам у и х, а коэффициент эластичности - относительным показателем силы связи, потому что выражает в процентах.

Для пояснения тесноты связи рассмотрим рисунок 3. Несмотря на всю важность измерения тесноты связи, в эконометрике больший практический интерес приобретает коэффициент детерминации r 2 xy , ибо он дает относительную меру влияния фактора на результат, фиксируя одновременно и роль ошибок, т.е. случайных составляющих в формировании моделируемой переменной. Чем ближе коэффициент детерминации к 1 , тем в большей степени уравнение регрессии пригодно для прогнозирования.

Рис. 3 Типы корреляции

а - полная корреляция: r xy = 1; б - сильная корреляция: r xy ? 0,8: 0,9;

в - слабая корреляция: r xy ? 0,2

корреляция линейный нелинейный регрессия

При оценке параметров уравнения регрессии применяется метод наименьших квадратов (МНК). При этом делаются определенные предпосылки относительно случайной составляющей e. В модели – случайная составляющая e представляет собой ненаблюдаемую величину. После того как произведена оценка параметров модели, рассчитывая разности фактических и теоретических значений результативного признака y , можно определить оценки случайной составляющей . Поскольку они не являются реальными случайными остатками, их можно считать некоторой выборочной реализацией неизвестного остатка заданного уравнения, т. е. ei.

При изменении спецификации модели, добавлении в нее новых наблюдений выборочные оценки остатков ei могут меняться. Поэтому в задачу регрессионного анализа входит не только построение самой модели, но и исследование случайных отклонений ei, т. е. остаточных величин.

При использовании критериев Фишера и Стьюдента делаются предположения относительно поведения остатков ei – остатки представляют собой независимые случайные величины и их среднее значение равно 0; они имеют одинаковую (постоянную) дисперсию и подчиняются нормальному распределению.

Статистические проверки параметров регрессии, показателей корреляции основаны на непроверяемых предпосылках распределения случайной составляющей ei. Они носят лишь предварительный характер. После построения уравнения регрессии проводится проверка наличия у оценок ei (случайных остатков) тех свойств, которые предполагались. Связано это с тем, что оценки параметров регрессии должны отвечать определенным критериям. Они должны быть несмещенными, состоятельными и эффективными. Эти свойства оценок, полученных по МНК, имеют чрезвычайно важное практическое значение в использовании результатов регрессии и корреляции.

Несмещенность оценки означает, что математическое ожидание остатков равно нулю. Если оценки обладают свойством несмещенности, то их можно сравнивать по разным исследованиям.

Оценки считаются эффективными , если они характеризуются наименьшей дисперсией. В практических исследованиях это означает возможность перехода от точечного оценивания к интервальному.

Состоятельность оценок характеризует увеличение их точности с увеличением объема выборки. Большой практический интерес представляют те результаты регрессии, для которых доверительный интервал ожидаемого значения параметра регрессии bi имеет предел значений вероятности, равный единице. Иными словами, вероятность получения оценки на заданном расстоянии от истинного значения параметра близка к единице.

Указанные критерии оценок (несмещенность, состоятельность и эффективность) обязательно учитываются при разных способах оценивания. Метод наименьших квадратов строит оценки регрессии на основе минимизации суммы квадратов остатков. Поэтому очень важно исследовать поведение остаточных величин регрессии ei. Условия, необходимые для получения несмещенных, состоятельных и эффективных оценок, представляют собой предпосылки МНК, соблюдение которых желательно для получения достоверных результатов регрессии.

Исследования остатков ei предполагают проверку наличия следующих пяти предпосылок МНК:

1. случайный характер остатков;

2. нулевая средняя величина остатков, не зависящая от xi;

3. гомоскедастичность – дисперсия каждого отклонения ei, одинакова для всех значений x ;

4. отсутствие автокорреляции остатков – значения остатков ei распределены независимо друг от друга;

5. остатки подчиняются нормальному распределению.

Если распределение случайных остатков ei не соответствует некоторым предпосылкам МНК, то следует корректировать модель.

Прежде всего, проверяется случайный характер остатков ei – первая предпосылка МНК. С этой целью стоится график зависимости остатков ei от теоретических значений результативного признака.

Линейная регрессия находит широкое применение в эконометрике в виде четкой экономической интерпретации ее параметров. Линейная регрессия сводится к нахождению уравнения вида

Или . (4.6)

Уравнение вида позволяет по заданным значениям фактора х иметь теоретические значения результативного признака, подставляя в него фактические значения фактора x . На графике теоретические значения представляют линию регрессии (рис. 4.2).

Рис. 4.2. Графическая оценка параметров линейной регрессии

Построение линейной регрессии сводится к оценке ее параметров и .Оценки параметров линейной регрессии могут быть найдены разными методами. Можно обратиться к полю корреляции и, выбрав на графике две точки, провести через них прямую линию (см. рис. 4.2). Далее по графику можно определить значения параметров. Параметр определим как точку пересечения линии регрессии с осью ,а параметр оценим, исходя из угла наклона линии регрессии, как ,где приращение результата у, a приращение фактора х, т. е.

Классический подход к оцениванию параметров линейной регрессии основан на методе наименьших квадратов (МНК).

МНК позволяет получить такие оценки параметров и ,при которых сумма квадратов отклонений фактических значений результативного признака (у) от расчетных (теоретических) минимальна:

Иными словами, из всего множества линий линия регрессии на графике выбирается так, чтобы сумма квадратов расстояний по вертикали между точками и этой линией была бы минимальной:

cследовательно,

Чтобы найти минимум функции (4.7), надо вычислить частные производные по каждому из параметров а и b и приравнять их к нулю.

Обозначим через S , тогда:

Преобразуя эту систему, получим следующую систему нормальных уравнений для оценки параметров и :

. (4.8)

. (4.8)

Решая систему нормальных уравнений (4.8) либо методом последовательного исключения переменных, либо методом определителей, найдем числовые значения искомых параметров и . Можно воспользоваться следующими готовыми формулами:

![]() . (4.9)

. (4.9)

Формула (4.9) получена из первого уравнения системы (4.8), если все его члены разделить на п.

где ковариация признаков;

Дисперсия признака x .

Ввиду того, что , ![]() ,получим следующую формулу расчета оценки параметра b

:

,получим следующую формулу расчета оценки параметра b

:

![]() . (4.10)

. (4.10)

Параметр называется коэффициентом регрессии. Его величина показывает среднее изменение результата с изменением фактора на одну единицу. Так, если в функции издержек (у - издержки (тыс. руб.), х - количество единиц продукции). То, следовательно, с увеличением объема продукции (х) на 1 ед. издержки производства возрастают в среднем на 2 тыс. руб., т. е. дополнительный прирост продукции на 1 ед. потребует увеличения затрат в среднем на 2 тыс. руб.

Возможность четкой экономической интерпретации коэффициента регрессии сделала линейное уравнение регрессии достаточно распространенным в эконометрических исследованиях.

Формально - значение у при х = 0. Если признак-фактор не имеет и не может иметь нулевого значения, то вышеуказанная трактовка свободного члена не имеет смысла. Параметр может не иметь экономического содержания. Попытки экономически интерпретировать параметр а могут привести к абсурду, особенно при < 0.

ГЛАВА 3. МОДЕЛЬ МНОЖЕСТВЕННОЙ

ЛИНЕЙНОЙ РЕГРЕССИИ

Основные понятия и уравнения множественной регрессии

На любой экономический показатель чаще всего оказывает влияние не один, а несколько совокупно действующих факторов. Например, объем реализации (Y ) для предприятий оптовой торговли может определяться уровнем цен (Х 1), числом видов товаров (Х 2), размером торговой площади (Х 3) и товарных запасов (Х 4). В целом объем спроса на какой-либо товар определяется не только его ценой (Х 1), но и ценой на конкурирующие товары (Х 2), располагаемым доходом потребителей (Х 3), а также некоторыми другими факторами. Показатель инновационной активности современных предприятий зависит от затрат на исследования и разработки (Х 1), на приобретение новых технологий (Х 2), на приобретение программных продуктов и средств (Х 3) и обучение и переподготовку кадров . В этих случаях возникает необходимость рассмотрения моделей множественной (многофакторной, многомерной) регрессии .

Модель множественной линейной регрессии является естественным обобщением парной (однофакторной) линейной регрессионной модели. В общем случае ее теоретическое уравнение имеет вид:

где Х 1 , Х 2 ,…, Х m – набор независимых переменных (факторов-аргументов); b 0 , b 1 , …, b m – набор (m + 1) параметров модели, подлежащих определению; ε – случайное отклонение (ошибка); Y – зависимая (объясняемая) переменная.

Для индивидуального i -го наблюдения (i = 1, 2, …, n ) имеем:

. (3.3)

. (3.3)

Здесь b j называется j -м теоретическим коэффициентом регрессии (частичным коэффициентом регрессии).

Аналогично случаю парной регрессии, истинные значения параметров (коэффициентов) b j по выборочным данным получить невозможно. Поэтому для определения статистической взаимосвязи переменных Y и Х 1 , Х 2 , …, Х m оценивается эмпирическое уравнение множественной регрессионной модели

в котором , – оценки соответствующих теоретических коэффициентов регрессии; е – оценка случайного отклонения ε.

Оцененное уравнение (3.4) в первую очередь должно описывать общий тренд (направление, тенденцию) изменения зависимой переменной Y . При этом необходимо иметь возможность рассчитать отклонения от этого тренда.

Для решения задачи определения оценок параметров множественной линейной регрессии по выборке объема n необходимо выполнение неравенства n ³ m + 1 (m – число регрессоров). В данном случае число v = n - m - 1 будет называться числом степеней свободы. Отсюда для парной регрессии имеем v = n - 2. Нетрудно заметить, что если число степеней свободы невелико, то и статистическая надежность оцениваемой формулы невысока. На практике принято считать, что достаточная надежность обеспечивается в том случае, когда число наблюдений по крайней мере в три раза превосходит число оцениваемых параметров k = m + 1. Обычно, статистическая значимость парной модели наблюдается при n ≥ 7.

Самым распространенным методом оценки параметров уравнения множественной линейной регрессионной модели является метод наименьших квадратов (МНК) . Напомним (см. раздел 2.4.1), что надежность оценок и статистических выводов, полученных с использованием МНК, обеспечивается при выполнении предпосылок Гаусса-Маркова. В случае множественной линейной регрессии к предпосылкам 1–4 необходимо добавить еще одну (пятую) – отсутствие мультиколлинеарности , что означает отсутствие линейной зависимости между объясняющими переменными в функциональной или статистической форме. Более подробно мультиколлинеарность объясняющих переменных будет рассмотрена в разделе (3.4). Модель, удовлетворяющая предпосылкам МНК, называется классической нормальной моделью множественной регрессии .

На практике часто бывает необходимо оценить силу влияния на зависимую переменную различных объясняющих (факторных) переменных. В этом случае используют стандартизованные коэффициенты регрессии и средние коэффициенты эластичности .

Стандартизированный коэффициент регрессии определяется по формуле:

(3.5)

(3.5)

где S (x j ) и S (y ) – выборочные средние квадратичные отклонения (стандарты) соответствующей объясняющей и зависимой переменных.

Средний коэффициент эластичности

(3.6)

(3.6)

показывает, на сколько процентов (от средней) изменится в среднем зависимая переменная Y при увеличении только j -й объясняющей переменной на 1 %.

Для модели с двумя объясняющими (факторными) переменными ![]() , после нахождения оценок

, после нахождения оценок ![]() , уравнение определяет плоскость в трехмерном пространстве. В общем случае m

независимых переменных геометрической интерпретацией модели является гиперплоскость в гиперпространстве.

, уравнение определяет плоскость в трехмерном пространстве. В общем случае m

независимых переменных геометрической интерпретацией модели является гиперплоскость в гиперпространстве.

Оценка параметров регрессионной модели

Для нахождения оценок параметров b j множественной линейной регрессионной модели (коэффициентов эмпирического уравнения регрессии) используется метод наименьших квадратов (МНК). Суть МНК заключается в минимизации суммы квадратов отклонений наблюдаемых выборочных значений y i зависимой переменной Y от их модельных оценок . Отклонение е i , соответствующее уравнению регрессии в i -м наблюдении (i = 1, 2, …, n ), рассчитывается по формуле:

Тогда для нахождения коэффициентов по МНК минимизируется следующая функция m + 1 переменных:

. (3.8)

. (3.8)

Необходимым условием минимума функции G

является равенство нулю всех ее частных производных по ![]() Частные производные квадратичной функции (3.8) являются линейными функциями относительно параметров:

Частные производные квадратичной функции (3.8) являются линейными функциями относительно параметров:

. (3.9)

. (3.9)

Приравнивая (3.9) к нулю, получаем систему m + 1 линейных нормальных уравнений с m + 1 неизвестными для определения параметров модели:

(3.10)

(3.10)

где j = 1, 2, …, m – определяет набор регрессоров.

Следует заметить, что включение в модель новых объясняющих переменных усложняет расчет коэффициентов множественной линейной регрессии путем решения системы (3.10) по сравнению с парной моделью. Система из трех уравнений, соответствующая модели с двумя объясняющими переменными ![]() , может быть легко решена методом определителей. Однако в общем виде решение системы (3.10) и анализ множественной регрессионной модели наиболее целесообразно проводить в векторно-матричной форме .

, может быть легко решена методом определителей. Однако в общем виде решение системы (3.10) и анализ множественной регрессионной модели наиболее целесообразно проводить в векторно-матричной форме .

Тогда, вводя матричные обозначения, запишем:

, , .

, , .

Здесь Y – n -мерный вектор-столбец наблюдений зависимой переменной; Х – матрица размерности n · (m + 1) значений объясняющих переменных x ij , в которой единица соответствует переменной при свободном члене ; – вектор-столбец размерности m + 1 оценок параметров модели (коэффициентов уравнения регрессии); е – вектор-столбец размерности n отклонений выборочных (реальных) значений y i зависимой переменной, от значений оценок , получаемых по уравнению регрессии.

В матричной форме модель (3.1) примет вид:

Y = XB + e. (3.11)

Оценкой этой модели по выборочным данным является уравнение (эмпирическая модель)

Предпосылки МНК (см. раздел 2.4.1.) в матричной форме можно записать следующим образом:

1. M (e) = 0; 2. D (e) = σ 2 I ; 3. Матрица ковариаций V (e) = M (e · e T ) = σ 2 E,

где e = – вектор-столбец случайных отклонений (ошибок);

I = – (n · 1) вектор;

E = E n × n = – единичная матрица;

– матрица ковариаций или ковариационная матрица

вектора случайных отклонений, которая является многомерным аналогом дисперсии одной переменной и в которой, если предпосылка о некоррелированности отклонений e i

и e j

выполняется, все элементы, не лежащие на главной диагонали, равны нулю, а элементы главной диагонали равны одной и той же дисперсии D

(e i

) = σ 2 ; 4. e – нормально распределенный случайный вектор, т. е. e ~ N

(0, σ 2 Е); 5. r

(X

) = m

+ 1 > n

– детерминированная матрица объясняющих переменных (регрессоров) имеет ранг r

, равный числу определяемых параметров модели m

+ 1, кроме того, число имеющихся наблюдений каждой из объясняющих переменных и зависимой переменной превосходит ранг матрицы Х

.

– матрица ковариаций или ковариационная матрица

вектора случайных отклонений, которая является многомерным аналогом дисперсии одной переменной и в которой, если предпосылка о некоррелированности отклонений e i

и e j

выполняется, все элементы, не лежащие на главной диагонали, равны нулю, а элементы главной диагонали равны одной и той же дисперсии D

(e i

) = σ 2 ; 4. e – нормально распределенный случайный вектор, т. е. e ~ N

(0, σ 2 Е); 5. r

(X

) = m

+ 1 > n

– детерминированная матрица объясняющих переменных (регрессоров) имеет ранг r

, равный числу определяемых параметров модели m

+ 1, кроме того, число имеющихся наблюдений каждой из объясняющих переменных и зависимой переменной превосходит ранг матрицы Х

.

Выполнение пятой предпосылки означает линейную независимость объясняющих переменных (линейную независимость столбцов матрицы Х ), т. е. отсутствие функциональной мультиколлинеарности.

Наша задача заключается в нахождении вектора оценок по МНК, который, при выполнении предпосылок 1–5, обладает наименьшим рассеянием относительно параметра B .

Воспользовавшись известными соотношениями матричной алгебры и правилами дифференцирования по векторному аргументу, получим необходимое условие минимума функции G (равенство нулю вектор-столбца частных производных )

Корреляционный анализ .

Уравнение парной регрессии .

Использование графического метода .

Этот метод применяют для наглядного изображения формы связи между изучаемыми экономическими показателями. Для этого в прямоугольной системе координат строят график, по оси ординат откладывают индивидуальные значения результативного признака Y, а по оси абсцисс - индивидуальные значения факторного признака X.

Совокупность точек результативного и факторного признаков называется полем корреляции .

На основании поля корреляции можно выдвинуть гипотезу (для генеральной совокупности) о том, что связь между всеми возможными значениями X и Y носит линейный характер.

Линейное уравнение регрессии имеет вид y = bx + a + ε

Здесь ε - случайная ошибка (отклонение, возмущение).

Причины существования случайной ошибки:

1. Невключение в регрессионную модель значимых объясняющих переменных;

2. Агрегирование переменных. Например, функция суммарного потребления – это попытка общего выражения совокупности решений отдельных индивидов о расходах. Это лишь аппроксимация отдельных соотношений, которые имеют разные параметры.

3. Неправильное описание структуры модели;

4. Неправильная функциональная спецификация;

5. Ошибки измерения.

Так как отклонения ε i для каждого конкретного наблюдения i – случайны и их значения в выборке неизвестны, то:

1) по наблюдениям x i и y i можно получить только оценки параметров α и β

2) Оценками параметров α и β регрессионной модели являются соответственно величины а и b, которые носят случайный характер, т.к. соответствуют случайной выборке;

Тогда оценочное уравнение регрессии (построенное по выборочным данным) будет иметь вид y = bx + a + ε, где e i – наблюдаемые значения (оценки) ошибок ε i , а и b соответственно оценки параметров α и β регрессионной модели, которые следует найти.

Для оценки параметров α и β - используют МНК (метод наименьших квадратов). Метод наименьших квадратов дает наилучшие (состоятельные, эффективные и несмещенные) оценки параметров уравнения регрессии.

Но только в том случае, если выполняются определенные предпосылки относительно случайного члена (ε) и независимой переменной (x).

Формально критерий МНК можно записать так:

S = ∑(y i - y * i) 2 → min

Система нормальных уравнений.

a n + b∑x = ∑y

a∑x + b∑x 2 = ∑y x

Для наших данных система уравнений имеет вид

15a + 186.4 b = 17.01

186.4 a + 2360.9 b = 208.25

Из первого уравнения выражаем а и подставим во второе уравнение:

Получаем эмпирические коэффициенты регрессии: b = -0.07024, a = 2.0069

Уравнение регрессии (эмпирическое уравнение регрессии):

y = -0.07024 x + 2.0069

Эмпирические коэффициенты регрессии a и b являются лишь оценками теоретических коэффициентов β i , а само уравнение отражает лишь общую тенденцию в поведении рассматриваемых переменных.

Для расчета параметров регрессии построим расчетную таблицу (табл. 1)

1. Параметры уравнения регрессии.

Выборочные средние.

Выборочные дисперсии:

Среднеквадратическое отклонение

1.1. Коэффициент корреляции

Ковариация .

Рассчитываем показатель тесноты связи. Таким показателем является выборочный линейный коэффициент корреляции, который рассчитывается по формуле:

Линейный коэффициент корреляции принимает значения от –1 до +1.

Связи между признаками могут быть слабыми и сильными (тесными). Их критерии оцениваются по шкале Чеддока:

0.1 < r xy < 0.3: слабая;

0.3 < r xy < 0.5: умеренная;

0.5 < r xy < 0.7: заметная;

0.7 < r xy < 0.9: высокая;

0.9 < r xy < 1: весьма высокая;

В нашем примере связь между признаком Y фактором X высокая и обратная.

Кроме того, коэффициент линейной парной корреляции может быть определен через коэффициент регрессии b:

1.2. Уравнение регрессии (оценка уравнения регрессии).

Линейное уравнение регрессии имеет вид y = -0.0702 x + 2.01

Коэффициентам уравнения линейной регрессии можно придать экономический смысл.

Коэффициент регрессии b = -0.0702 показывает среднее изменение результативного показателя (в единицах измерения у) с повышением или понижением величины фактора х на единицу его измерения. В данном примере с увеличением на 1 единицу y понижается в среднем на -0.0702.

Коэффициент a = 2.01 формально показывает прогнозируемый уровень у, но только в том случае, если х=0 находится близко с выборочными значениями.

Но если х=0 находится далеко от выборочных значений х, то буквальная интерпретация может привести к неверным результатам, и даже если линия регрессии довольно точно описывает значения наблюдаемой выборки, нет гарантий, что также будет при экстраполяции влево или вправо.

Подставив в уравнение регрессии соответствующие значения х, можно определить выровненные (предсказанные) значения результативного показателя y(x) для каждого наблюдения.

Связь между у и х определяет знак коэффициента регрессии b (если > 0 – прямая связь, иначе - обратная). В нашем примере связь обратная.

1.3. Коэффициент эластичности .

Коэффициенты регрессии (в примере b) нежелательно использовать для непосредственной оценки влияния факторов на результативный признак в том случае, если существует различие единиц измерения результативного показателя у и факторного признака х.

Для этих целей вычисляются коэффициенты эластичности и бета - коэффициенты.

Средний коэффициент эластичности E показывает, на сколько процентов в среднем по совокупности изменится результат у от своей средней величины при изменении фактора x на 1% от своего среднего значения.

Коэффициент эластичности находится по формуле:

Коэффициент эластичности меньше 1. Следовательно, при изменении Х на 1%, Y изменится менее чем на 1%. Другими словами - влияние Х на Y не существенно.

Бета – коэффициент

Бета – коэффициент показывает, на какую часть величины своего среднего квадратичного отклонения изменится в среднем значение результативного признака при изменении факторного признака на величину его среднеквадратического отклонения при фиксированном на постоянном уровне значении остальных независимых переменных:

Т.е. увеличение x на величину среднеквадратического отклонения S x приведет к уменьшению среднего значения Y на 0.82 среднеквадратичного отклонения S y .

1.4. Ошибка аппроксимации .

Оценим качество уравнения регрессии с помощью ошибки абсолютной аппроксимации. Средняя ошибка аппроксимации - среднее отклонение расчетных значений от фактических:

Ошибка аппроксимации в пределах 5%-7% свидетельствует о хорошем подборе уравнения регрессии к исходным данным.

Поскольку ошибка меньше 7%, то данное уравнение можно использовать в качестве регрессии.